Anlässlich des Forschungsprojektes NoHate@WebStyria sprach das Projektteam mit Matthias C. Kettemann, Forschungsprogrammleiter am Leibniz-Institut für Medienforschung, über Online Hate Speech und Corona, zu welchen Inhalten häufig gehated wird und wie eine kleine Minderheit den Diskurs im Web verschieben kann.

Hate Speech im Netz: „Plattformen vertrauen ihren Algorithmen zu sehr und hinterfragen zu wenig“

„Plattformen vertrauen ihren Algorithmen zu sehr und hinterfragen zu wenig“ FH JOANNEUM, 22. April 2020

Vertrauen ist gut - Kontrolle ist besser. Matthias C. Kettemann spricht über Hate Speech im Netz und wie man diese vermeiden und verhindern kann. © Jon Tyson Unsplash

Das Forschungsprojekt NoHate@WebStyria beschäftigt sich mit dem Spannungsverhältnis: Wo hört freie Meinungsäußerung auf und wo fängt Hassrede an? Matthias C. Kettemann ist Experte für Internet- und Völkerrecht, Meinungsäußerungs-Governance und Internet-Politik. In Forschungsprojekten untersuchte er unter anderem die Regelentwicklung von Facebook und nach welchen Gesichtspunkten Beiträge auf großen und kleineren Plattformen gelöscht werden. Im Interview spricht er über Online Hate Speech und Corona.

Die FAZ schreibt „Die Algorithmen tun, was sie sonst nie getan haben: Sie unterdrücken Schwachsinn.“ Nun könnte man Hate Speech als qualifizierten Schwachsinn beschreiben – glauben Sie, dass die Corona-Krise einen Wandel der Kultur im Internet mit sich bringen könnte?

Matthias C. Kettemann: Nein, nicht hinsichtlich Meinungsäußerungs-Governance. Die Krise wird viele Aspekte unseres Zusammenlebens ändern, aber nicht in der Regulierung von Online-Rede, weil sich hier keine gänzlich neuen Herausforderungen stellen. Was sich getan hat, ist, dass Moderatorinnen und Moderatoren nicht jeden Tag Inhalte löschen können, weil sie aufgrund der aktuellen Maßnahmen zuhause sind. Daher müssen die großen Plattformen viel stärker auf algorithmisches Meinungsäußerungsmanagement zurückgreifen. Sie wissen aber, dass ihre automatisierten Tools bei der Erkennung semantischer Unterschiede zwischen beispielsweise Humor und Hate Speech oder erlaubter Kritik und Beleidigung viel schlechter sind als Menschen. Deswegen kommt es zu vielen falsch gelöschten Inhalten und es bleiben andere Inhalte, die illegal sind, online. Das erkennen die Plattformen auch an: Twitter hat angekündigt, dass alle derzeit gelöschten Inhalte nicht als Strikes gegen den Account gewertet werden (Anmerkung: Bei einer gewissen Anzahl von Strikes kann ein Account gesperrt oder gelöscht werden).

Wenn wir über Hate Speech sprechen, ist eine Herausforderung, dass es keine allgemeingültige Definition gibt. Wie geht es Ihnen in Bezug auf Ihre Arbeit mit Definitionsfragen zu Hate Speech?

Kettemann: „Hate Speech“ ist so wie „Governance“ ein nützlicher Begriff, der aber sehr diffus ist und im strafrechtlichen Kontext wenig bringt. Sobald wir mit Gerichten arbeiten, brauchen wir Tatbestände und Hate Speech ist kein Tatbestand nach österreichischem oder deutschem Strafrecht. Meiner Meinung nach sollte man sich mit Definitionen nicht zu lange aufhalten, die Frage ist eher, was man damit machen will. Geht es in meinem Projekt um Aktivismus, dann werde ich eine Definition verwenden, die etwas breiter ist, ist es eine Kooperation mit Staatsanwaltschaften, dann werde ich Hate Speech zurückführen auf den Kern der strafrechtlich relevanten Tatbestände.

Sie analysieren in Ihren Projekten unter anderem gelöschte Forenbeiträge und beschäftigen sich mit der Entwicklung von Regeln großer Plattformen wie zum Beispiel Facebook. Was können Sie über das Löschverhalten dieser Plattformen berichten?

Kettemann: Ja, wir haben unter anderem letztes Jahr eine Studie zur internen Ordnung von Facebook durchgeführt, also wie Facebook-Regeln entstehen und wie die Plattform löscht. In diesem und weiteren Projekten konnten wir erkennen: Viele Inhalte werden gelöscht, obwohl sie rechtlich in keine Kategorie passen, also strafrechtlich nicht relevant sind! Plattformen können grundsätzlich mehr löschen als sie müssen, weil sie beispielsweise ein zivileres Forum sein wollen. Das ist von ihrem Hausrecht umfasst. Problematisch wird es, wenn die Plattformen größer werden, sodass sie entscheidende Auswirkungen auf den demokratischen Diskurs haben – wie es bei Facebook der Fall ist. Aufgrund der Bedeutung der Plattform müssen Grundrechte horizontal angewendet werden. So darf Facebook zum Beispiel Accounts nicht einfach nach eigenem Ermessen und ohne Angabe von legitimen Gründen löschen. Das haben etwa die Verfassungsgerichte Deutschlands und Italiens bestätigt.

Die andere Seite ist: Die Unternehmen haben immer noch die Tendenz, schneller zu löschen oder gelöschte Inhalte offline zu halten, und ihre Algorithmen einmal darauf auszurichten. Jede Wiederherstellung von Inhalten ist herausfordernd, kostet Zeit und Nachdenken, Plattformen vertrauen ihren Algorithmen noch immer zu sehr und hinterfragen diese zu wenig.

Matthias C. Kettemann ist Experte für Internet- und Völkerrecht. Foto: HBI

Welche Inhalte und betroffene Gruppen erkennen Sie in den gelöschten Beiträgen?

Kettemann: Wir sehen sehr viele antifeministische, misogyne Inhalte, sexuelle Anspielungen oder verbale sexuelle Gewalt. Personen mit Migrationshintergrund sehen sich stark Hate Speech ausgesetzt, oft in Verbindung mit Fake News. Inhalte, die entweder Fake News sind oder nur einen sehr kleinen Ausschnitt der Wirklichkeit wiedergeben, werden zum Anlass genommen, Hate Speech zu posten. Da sind natürlich Personen, die intersektionell diskriminiert werden, das heißt aus verschiedenen Gründen zu verletzlichen Gruppen gehören, besonders betroffen. Wir sehen auch sehr viel Hate Speech zu Politikerinnen wie Sigi Maurer oder Renate Künast und besonders zu Politikerinnen mit Migrationshintergrund wie Alma Zadić.

Inwieweit sehen Sie eine Veränderung des Verhaltens auf Social Media durch Hate Speech?

Kettemann: Hate Speech hat jedenfalls einen sehr negativen Einfluss auf die Art und Weise, wie öffentlich diskutiert wird. Es betrifft ja nicht nur die einzelne Person, die angesprochen wird. Je häufiger Hate Speech in einem Forum auftritt, desto stärker sehen wir eine Verrohung des Diskurses. Die Diskussionskultur des Forums verschlechtert sich. Gleichzeitig werden Menschen, die Opfer von Hate Speech sind, von den Foren verdrängt. Hier ist Gegenrede wichtig – und Anzeigen und konsequente Strafverfolgung, wenn ein Tatbestand erfüllt ist.

Welche Motive und Ziele erkennen Sie bei den Ausübenden?

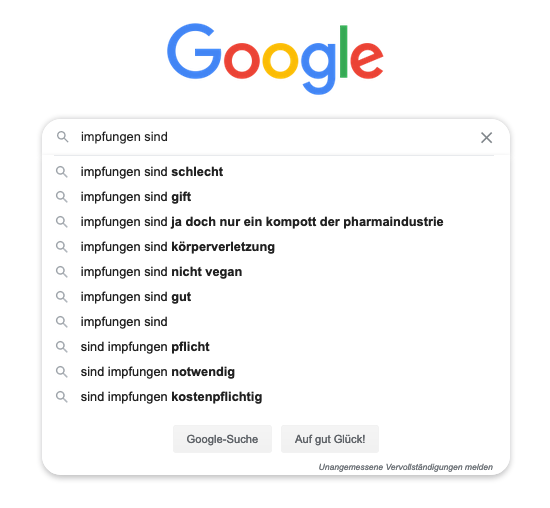

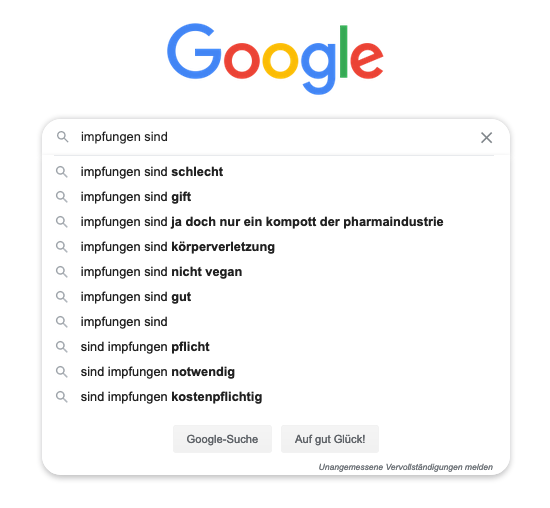

Kettemann: Einerseits Silencing, also Opfer mundtot zu machen. Es ist eine kleine Minderheit, die Hate Speech verbreitet. Ganz generell gilt: 90 % der Inhalte werden von 5 bis 10 % der Userinnen und User gepostet, das heißt, ein sehr kleiner Teil ist tendenziell einflussreicher. Das gilt auch und gerade für Hate Speech. Man darf nicht in die Falle laufen, dass man in den Diskurs einer solchen Bubble schaut und das für repräsentativ hält. Andererseits darf man ihn auch nicht ignorieren oder auch nur auf Mainstream-Plattformen schauen: Die Rechten wandern zu alternativen Plattformen ab und parallel dazu werden rechtsextreme Inhalte immer mehr zum Mainstream, da viele Menschen dazu übergegangen sind, Postings nicht zu melden, sondern wegzuklicken. Das ist auch etwas, das jede und jeder von uns besser machen könnte, sowohl rechtsextreme Inhalte als auch Fake News stärker zu melden. Ein Beispiel, was passieren kann, wenn das verabsäumt wird, ist das Thema Impfen. Wenn man „Impfungen sind“ auf Google eingibt, dann schlägt Google nicht „gut“, sondern „Gift“ oder „schlecht“ vor. Diese Selbstvervollständigungsfunktion folgt zwar auch anderen Gesetzmäßigkeiten, aber das Problem ist vom Prinzip her dasselbe: nicht gegen Hate Speech oder Falschinformation auftreten, heißt diese im Endeffekt zu unterstützen.

Die Selbstvervollständigungsfunktion auf Google und die Ergebnisanzeigen.

Welche neuen Herausforderungen sehen Sie für Medien und Social-Media-Beauftragte?

Kettemann: Unternehmen treten immer stärker hinaus in die Öffentlichkeit, so können sie in Shitstorms hineingeraten, die inhaltlich nichts mit ihnen zu tun haben. Andererseits sind wir als Gesellschaft auch noch nicht in der Lage, Unternehmen die richtige Kommunikationsrolle zuzuordnen. Möchten wir, dass sich ein Möbelhaus in den politischen Diskurs einmischt? Eher nicht? Aber soll ein Kleidungsunternehmen Stellung beziehen zu Arbeiterinnen- und Arbeiterrechten in den Produktionsländern? Schon eher. Auch Medien selbst sind auf den Plattformen zum Thema geworden. Medien reflektieren ihre Rolle in der Gesellschaft viel stärker. Vor allem öffentlich-rechtliche Medien stellen sich die Frage ihrer Legitimität beziehungsweise ob ihre Rolle neu zu konzipieren ist: Unsere Gesellschaft beruht auf gemeinsam geteilten Informationen. Wir brauchen also verlässliche gesellschafltiche Kommunikationsforen in denen Meinungsvielfalt herrscht. In Deutschland und Österreich wird diese durch die öffentlich-rechtlichen Medien dargestellt. Hier stellt sich aber die Frage, wie diese im Internet aussieht, wo öffentlich-rechtliche Medien nicht in dem Ausmaß aktiv tätig werden dürfen wie andere Content-Produzentinnen und Produzenten. Somit überlassen sie das Feld Akteurinnen und Akteuren, die nicht an die Meinungsvielfaltspflicht gebunden sind, sondern ökonomischen Logiken folgen.

Wie könnte man die Rolle der Medien neu definieren?

Kettemann: Das ist eine sehr große Frage und nicht eindeutig zu beantworten. Man könnte etwa die Anreizstrukturen adaptieren und außerhalb der Werbefinanzierung Lösungen für stabilere Finanzierungsmodelle für Medien finden. Eine Variante wäre, öffentliche Förderungen für Inhalte und nicht für Akteurinnen und Akteure zu vergeben. So könnten sich Medienunternehmen um die Zurverfügungstellung von gesellschaftlich wertvollen Inhalte bewerben. Das Problem ist, dass das auch missbraucht werden könnte, um die Legitimität der öffentlich-rechtlichen Medien noch weiter in Frage zu stellen. Die Förderung des Qualitätsjournalismus ist europarechtlich wie verfassungsrechtlich schwierig. Besonders in Krisenzeiten wie jetzt zeigt sich aber, wie ungemein bedeutend stabile öffentliche Kommunikationskanäle sind, die nicht primär auf Profit gebürstet sind.