Was versteht man unter „Big Data“? Was braucht es, um Erkenntnisse aus großen Datensätzen zu gewinnen? Was haben Statistik und Mathematik damit zu tun? Wolfgang Granigg, interimistischer Studiengangsleiter von „Data and Information Science“* an der FH JOANNEUM, gibt Antworten.

Viele bestehende Daten. Viele benötigte Kompetenzen.

Wolfgang Granigg, 05. April 2018

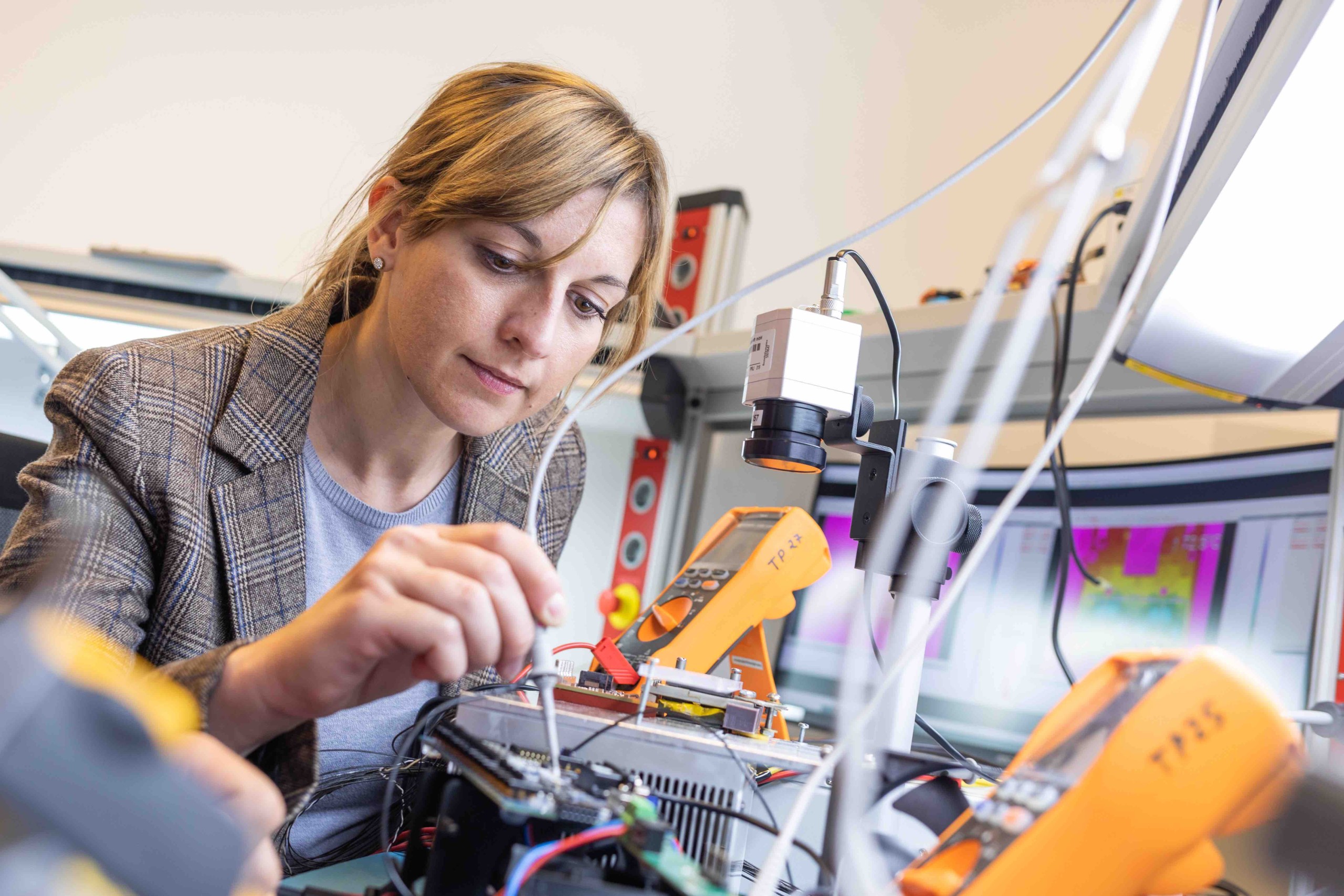

Große Volumina an vielfältigen Daten mit großer Geschwindigkeit verarbeiten – vor dieser Aufgabe stehen „Big Data“-Expertinnen und -Experten. (© FH JOANNEUM / Manfred Terler)

„Big Data“ ist weit über den traditionellen IT-Bereich hinaus ein nahezu omnipräsenter Fachausdruck. Neben „Cloud Computing“ und „Internet of Things (IoT)“ ist auch „Big Data“ für einige der großen IT-Stoßrichtungen des aktuellen Jahrzehnts verantwortlich. Wegen der breiten Verwendung dieses Begriffs werden mit ihm vermehrt auch Dinge und Aktivitäten in Verbindung gebracht, die mit dem Begriff „Big Data“ im Grunde nicht viel zu tun haben.

Laut gängigen Definitionen bezieht sich das „big“ in „Big Data“ vor allem auf drei Eigenschaften, die diesen Begriff beziehungsweise die im Zentrum stehenden Daten näher definieren: Erstens ist damit „großes Volumen“ gemeint, zweitens „große Geschwindigkeit“ und drittens „große Vielfalt“. Man könnte also „Big Data“ zusammenfassend als Gebiet beschreiben, bei dem „große Volumina an vielfältigen Daten mit großer Geschwindigkeit verarbeitet werden“. Das zu diesen drei Eigenschaften hinzugefügte Verb „verarbeiten“ vereint die zentralen Herausforderungen dieses Gebiets: Nämlich Daten, die diese drei Eigenschaften mit sich bringen, effektiv und effizient zu sammeln, zu importieren, zu speichern, zu aktualisieren, verfügbar zu halten, zu analysieren, zu aggregieren, zu exportieren, aufzubereiten oder zu übermitteln.

Mathematische Expertise und IT-Kompetenzen im Einklang

Während die meisten Aktivitäten im Kern informationstechnologische Kompetenzen erfordern, benötigen die Analyse und die Aggregation von Daten mathematische beziehungsweise statistische Fachexpertise. Die Mathematik liefert dabei vor allem die Basis für die anspruchsvollen Analysemethoden in den Bereichen der beschreibenden, der schließenden sowie der explorativen Statistik. Auch die Aggregationsmethoden aus der multivariaten Statistik basieren auf Zusammenhängen der höheren Mathematik: insbesondere der linearen Algebra sowie der Numerik.

Zusammengefasst bedeutet dies, dass „Big Data“ zwar in vielen Bereichen eine informationstechnologische Disziplin, im Kern bei der Analyse und Aggregation der Daten jedoch eine primär mathematisch-statistische Fachrichtung ist. Insofern braucht es nicht „nur“ Kompetenzen aus den Bereichen Programmierung und Datenbankmanagement, sondern insbesondere auch aus den Bereichen Mathematik und Statistik. Berücksichtigt man noch, dass auch ethische und rechtliche Aspekte überaus wichtige Rahmenbedingungen für „Big Data“ darstellen, bleibt als Folge nur noch „Big Data“ als interdisziplinäre Disziplin zu bezeichnen. Wer sich also heute umfassend mit „Big Data“ auseinandersetzen möchte, benötigt ein ganzes Bündel an Kompetenzen.

Das ab Herbst 2018 neu startende Master-Studium „Data and Information Science“ an der FH JOANNEUM hat von Anfang an eine umfassende und praxisnahe Ausbildung zum Ziel. So wird den Studierenden das ganze Bündel an notwendigen Kompetenzen vermittelt: von IT über Mathematik bis hin zu den ethischen und rechtlichen Rahmenbedingungen.